ChatGPT & GDPR: Gaan ze hand in hand of niet?

Geschreven door: Simon Geens

Het gebruik van ChatGPT, en andere gelijkaardige programma’s, neemt steeds toe. Meer en meer bedrijven willen het voor allerlei opdrachten en processen toepassen.

In deze blogpost gaan de de AI Verordering (AI Act) toelichten en wat dit als gevolg heeft voor programma’s zoals oa. ChatGPT. Daarnaast kijken we ook hoe we ChatGPT toch op een GDPR-vriendelijke manier kunnen gebruiken.

De AI Act in een notendop

Tot voor kort bestond er eigenlijk zeer weinig wettelijk initiatief rond het gebruik van AI (waaronder ChatGPT valt). De technologie evolueert dan ook razendsnel. Stilaan komt er toch verandering in, en ondertussen werd er met het ontwerp van de AI Verordening (de AI Act) wel een wetgevend initiatief genomen, al zal er aan de lidstaten nog twee jaar de tijd gegeven worden om deze te implementeren.

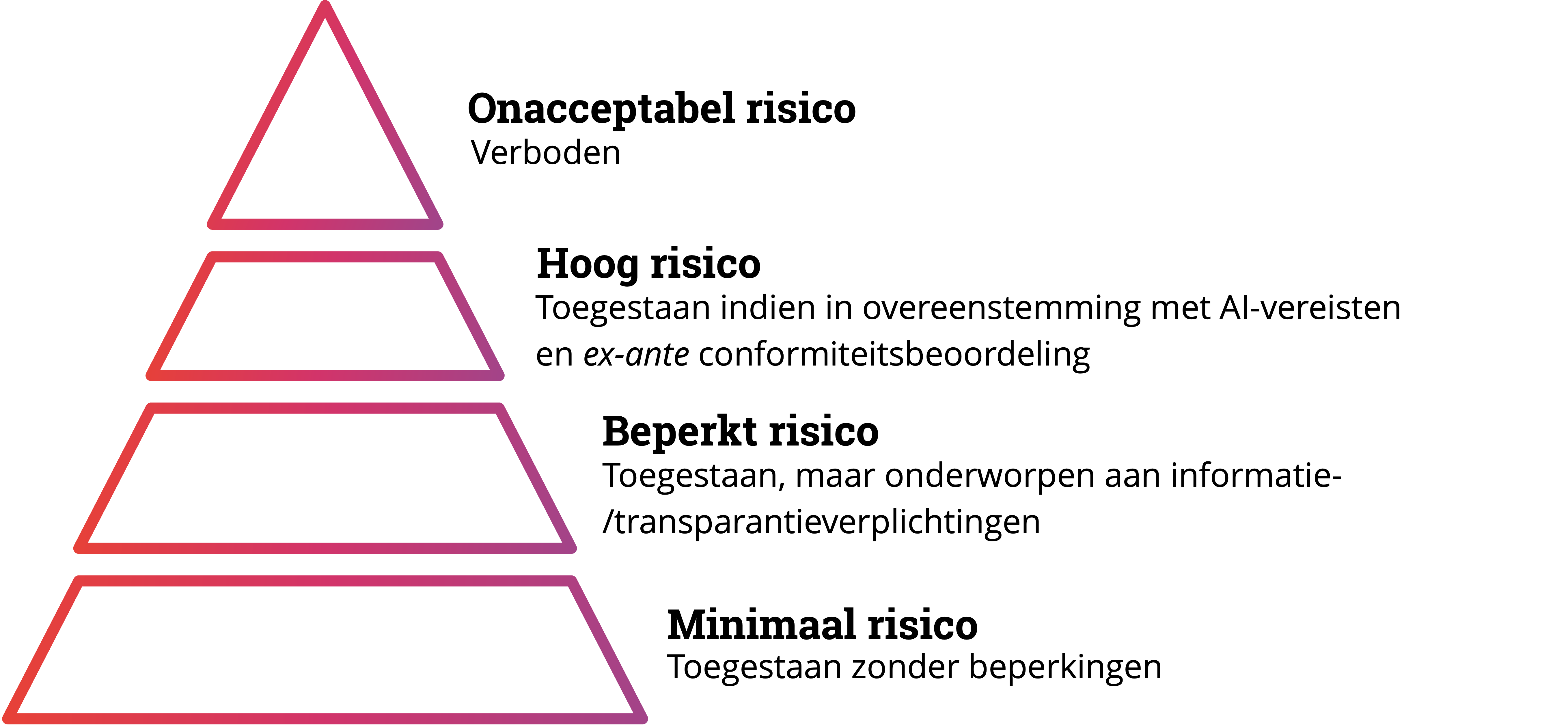

Het initiële voorstel voor de AI-act was doelgeörienteerd; AI-systemen werden geclassificeerd als (i) verboden, (ii) hoog risico, (iii) laag risico of (iv) zonder risico, en dit op basis van het doel waarvoor ze ontworpen waren.

Afhankelijk van de classificatie van het AI-systeem zouden er andere regels gelden. Concreet betekent dit dat er in de eerste versie van het voorstel enkel werd gekeken naar het doel waarvoor de aanbieders het AI-systeem ontwikkeld hebben, zonder oog te hebben voor de manier waarop de gebruiker het AI-systeem zou toepassen.

In november 2022, wanneer ChatGPT mainstream aandacht kreeg, merkte de EU-wetgever dat deze logica niet gehanteerd kan worden bij AI-systemen die voor een algemeen doel ontworpen zijn. ChatGPT kan namelijk voor verschillende doeleinden gebruikt worden afhankelijk van de input van de gebruiker, dus het was nodig om het voorstel te wijzigen en tegemoet te komen aan deze recente ontwikkelingen.

Wat is een AI-systeem volgens de AI Verordening?

Volgens de definities in artikel 3 uit het ontwerp van de AI Verordening is een AI-systeem het volgende:

“software die is ontwikkeld aan de hand van een of meer van de technieken en benaderingen die zijn opgenomen in de lijst van bijlage I en die voor een bepaalde reeks door mensen gedefinieerde doelstellingen output kan genereren, zoals inhoud, voorspellingen, aanbevelingen of beslissingen die van invloed zijn op de omgeving waarmee wordt geïnterageerd”

ChatGPT zal uiteraard als een AI-systeem worden aangemerkt. Er dient echter bekeken te worden onder welke categorie van AI-systeem valt om te weten welke verplichtingen en/of beperkingen er gelden voor het gebruik van ChatGPT.

Onder welke risicoklasse valt ChatGPT?

ChatGPT valt niet onder de verboden praktijken op het gebied van artificiële intelligentie, zoals voorzien in artikel 5 van de AI Verordening, maar kan mogelijk wel onder AI-systemen met een hoog risico vallen afhankelijk van de manier waarop deze technologie aangewend wordt door de gebruiker.

Artikel 6 van de AI Verordening stelt het volgende:

“1. Ongeacht of een AI-systeem los van in de punten a) en b) bedoelde producten in de handel wordt gebracht of in gebruik wordt gesteld, wordt een AI-systeem als AI-systeem met een hoog risico beschouwd wanneer aan beide van de volgende voorwaarden is voldaan:

- het AI-systeem is bedoeld om te worden gebruikt als veiligheidscomponent van een product of is zelf een product dat valt onder de in bijlage II opgenomen harmonisatiewetgeving van de Unie;

(b) voor het product waarvan het AI-systeem de veiligheidscomponent vormt of voor het AI-systeem als product zelf moet een conformiteitsbeoordeling van een derde partij worden uitgevoerd met het oog op het in de handel brengen of in gebruik stellen van dat product overeenkomstig de in bijlage II opgenomen harmonisatiewetgeving van de Unie.

- Naast de in lid 1 bedoelde AI-systemen met een hoog risico worden ook AI-systemen zoals bedoeld in bijlage III als AI-systeem met een hoog risico beschouwd.”

ChatGPT voldoet niet aan de cumulatieve voorwaarden gesteld in de eerste alinea, aangezien dit geen veiligheidscomponent van een product is, noch onder enige harmonisatiewetgeving uit bijlage II valt.

Om vast te stellen in welke situaties ChatGPT wel als hoog risico AI-systeem gezien kan worden, moet er gekeken worden naar bijlage III van de Verordening, waar de doelen worden beschreven die tot gevolg hebben dat een AI systeem wordt aangemerkt als hoog risico.

Maar zoals eerder vermeld, is het de gebruiker zelf die beslist hoe een AI-systeem dat niet voor een specifiek doel ontwikkeld werd gebruikt zal worden. Bijgevolg het is de gebruiker die bepaalt welke risicoclassificatie er van toepassing is, afhankelijk van de doeleinden waarvoor ChatGPT gebruikt wordt. Het gebruik van ChatGPT kan bijvoorbeeld als hoog risico geclassificeerd worden wanneer het gebruikt wordt in de context van aanwervingsprocedures en personeelsbeheer:

“4. werkgelegenheid, personeelsbeheer en toegang tot zelfstandige arbeid:

`

- AI-systemen die bedoeld zijn voor de aanwerving of selectie van natuurlijke personen, met name voor het bekendmaken van vacatures, het screenen of filteren van sollicitaties, de evaluatie van kandidaten tijdens interviews of tests;

- AI-systemen die bedoeld zijn voor het nemen van besluiten over de bevordering en beëindiging van arbeidsgerelateerde contractuele relaties, voor de toewijzing van taken en voor het toezicht op en de evaluatie van prestaties en gedrag van personen in dergelijke relaties;”

Wanneer het AI-systeem als hoog risico wordt geclassificeerd, dan worden er door de Verordening extra kwaliteitsvereisten gesteld aan de data. Lid 1 van artikel 10 stelt het volgende:

“AI-systemen met een hoog risico die technieken gebruiken die het trainen van modellen met data omvatten, worden ontwikkeld op basis van datareeksen voor training, validatie en tests die voldoen aan de kwaliteitscriteria als bedoeld in de leden 2 tot en met 5.”

Deze vereisten omvatten o.a. de kwaliteit van de datasets die gebruikt worden voor training (relevant, representatief, zonder fouten en volledig), het toepassen van de juiste data governance en management, etc.

Daarnaast valt ChatGPT ook onder artikel 52 van de Verordening aangezien dit gericht is op natuurlijke personen. Hierdoor geldt er een bijkomende transparantieverplichting. Natuurlijke personen moeten worden geïnformeerd dat zij interageren met een AI-systeem, tenzij de omstandigheden en de gebruikscontext dit duidelijk maken. Verder moeten er ook waarborgen aanwezig zijn die voorkomen dat er output wordt gegeven die in strijd is met EU-regelgeving en moet er een samenvatting worden gegeven van de trainingdata.

ChatGPT en de GDPR: Gaan ze hand in hand of niet?

Het is belangrijk om te weten dat enkele karakteristieken van AI-systemen niet te rijmen vallen met principes uit de GDPR:

| Principe | AI eigenschap |

| Minimale gegevensverwerking | AI wordt getraind met enorm grote datasets. (Bv. ChatGPT is getraind op een dataset van 300 miljard woorden) |

| Doelbeperking | Bij de ontwikkeling van AI systemen kan men vaak nog geen inschatting maken van de verschillende doeleinden waarvoor het gebruikt zal worden (bv. ChatGPT is een AI-systeem met een algemeen doel). |

| Opslagbeperking | In tegenstelling tot de initiële trainingsdata die gemakkelijk verwijderd kan worden, is het minder evident om een AI-systeem aan te passen op zodanige manier dat de output niet meer gebaseerd is op persoonsgegevens waarvan de bewaartermijn verlopen is. |

| Transparantie | Veel AI-systemen worden beschouwd als een “black-box”, wat het quasi onmogelijk maakt om de interne processen in mensentaal begrijpbaar te maken voor alle gebruikers. |

| Juistheid | Sommige AI-systemen die getraind worden op publiek beschikbare gegevens (zoals ChatGPT) kunnen een onjuiste output produceren. Dit kan te wijten zijn aan incorrecte trainingsdata of een fenomeen dat beschreven wordt als AI-hallucinatie waarbij het AI-systeem bepaalde informatie zal uitvinden om toch een antwoord te kunnen geven. |

Uiteraard doet de AI Verordening geen afbreuk aan de GDPR, want ook de verplichtingen die voortvloeien uit de GDPR blijven van toepassing.

Zo zal het gebruik van ChatGPT een legale basis moeten hebben, zullen de nodige maatregelen genomen moeten worden om de risico’s voor betrokkenen te beperken, moeten de DPIAs en TIAs uitgevoerd worden,…

Conclusie? ChatGPT is in principe niet verboden om te gebruiken, ook niet meer in Italië, maar uiteraard moet er hierbij dan ook met de nodige voorzichtigheid gehandeld worden. Een onderscheid kan gemaakt worden tussen de doelstellingen waarvoor ChatGPT gebruikt wordt.

Persoonsgegevens (potentiële) werknemers

Het gebruik van ChatGPT waarbij persoonsgegevens van werknemers en sollicitanten verwerkt worden, moet in de praktijk vermeden worden.

Bovenop het feit dat het gebruik van ChatGPT in deze context als hoog risico wordt aanschouwd, is het vinden van de correcte rechtsgrond voor deze verwerking problematisch. De enige eventuele rechtsgrond voor de verwerking is toestemming. De praktijk leert echter dat vrije toestemming in een machtsrelatie zoals deze tussen een werkgever-werknemer en een werkgever-sollicitant zeer onwaarschijnlijk is. Toestemming is in dit geval namelijk enkel geldig wanneer de weerhouding ervan door de werknemer of sollicitant nooit tot negatieve gevolgen kan leiden.

Het is dan ook af te raden dat AI-systemen zoals ChatGPT gebruikt worden wanneer dit het verwerken van persoonsgegevens van personeelsleden en sollicitanten tot gevolg heeft.

Persoonsgegevens leveranciers, klanten en consumenten

Of het gebruik van ChatGPT voor het verwerken van persoonsgegevens van leveranciers, klanten en consumenten toegestaan is, zal afhangen van de concrete situatie.

Indien het mogelijk is voor de betrokkenen om toestemming vrij te geven, is het mogelijk om ChatGPT te gebruiken. Uiteraard moet in voorkomend geval ook voldaan zijn aan alle andere vereisten van de GDPR (o.a. eventueel het uitvoeren van een DPIA, TIA,…). Betrokkenen moeten hierover ook steeds duidelijk en correct geïnformeerd worden.

Gevoelige of vertrouwelijke persoonsgegevens

Je mag niet vergeten dat OpenAI, het bedrijf dat ChatGPT ontwikkeld heeft, een privébedrijf is. Je hebt dus geen garantie dat wanneer je gevoelige of vertrouwelijke gegevens in ChatGPT invoert, deze informatie ook geheim zal blijven. Je input wordt namelijk gebruikt door OpenAI om het algoritme te trainen, en is dus ook beschikbaar voor andere gebruikers van ChatGPT.

In april 2023 meldde Samsung bijvoorbeeld een lek van vertrouwelijke gegevens in verband met de ontwikkeling van semiconductoren nadat werknemers ChatGPT hadden gebruikt om een fout in de code te proberen oplossen.

Conclusie

Het gebruik van ChatGPT, en andere AI-toepassingen, kan zeer interessant zijn. Met de AI Verordening wordt er nu ook meer richting gegeven over hoe deze technologie kan toegepast worden. Het blijft echter belangrijk om niet enkel naar de AI Verordening maar ook naar de GDPR te kijken wanneer deze technologie toegepast zal worden in de praktijk.

Wanneer je binnen jouw onderneming gebruik wil maken van ChatGPT is het dus belangrijk om ervoor te zorgen dat aan alle verplichtingen, zowel uit de AI Verordening als uit de GDPR, maar ook eventueel andere relevante wetgevingen, voldaan wordt.

Indien je graag gebruik wenst te maken van ChatGPT, of andere AI-toepassingen, maar hierbij vragen hebt, aarzel dan niet om contact op te nemen met ons. Wij staan jouw onderneming hierin graag bij.